Replytocom в ссылках WordPress

Здравствуйте! Сегодня мне хотелось бы вернуться снова к теме комментариев на WordPress, а точнее к ссылкам ответа на комментарий. Мне как никогда было обидно столкнуться с этой проблемой, в частности с Replytocom.

После запуска нового поискового алгоритма под названием Панда Google всерьез начал борьбу с дубликатами. И это уже ощутили западные блоггеры, после того как их позиции сильно упали в поисковой выдаче. К этому нужно отнестись серьезно.

Что такое Replytocom

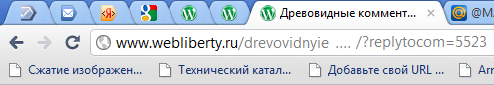

При использовании древовидных комментариев движок генерирует дополнительные страницы, дублирующие основной контент, которые выглядят следующим образом:

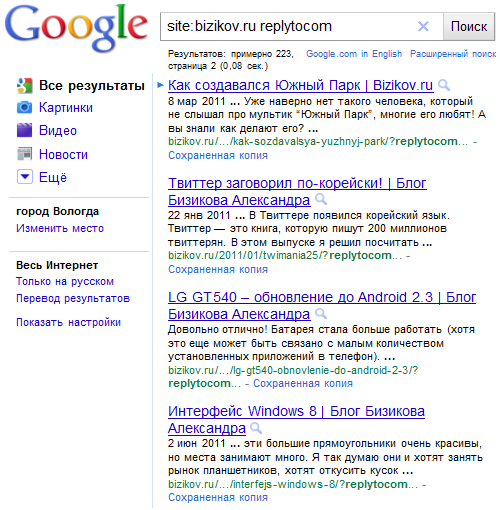

https://site.ru/post?replytocom=7062Как-то раз я делал свои комментарии древовидными и столкнулся с такой проблемой, о чем уже писал в посте о подводных камнях древовидной структуры. Сейчас у меня отключена древовидная структура и лишние страницы удалены из индекса. Так как объяснять лучше на примере, то я нашел поиском один из многочисленных (!) сайтов, у которого есть проблемы с этим. Выполняя несложный запрос в Google:

site:site.ru replytocomгде site.ru — адрес Вашего сайта, а replytocom — страницы на заданном сайте с этим параметром. Если часть найденных документов будет скрыта и отмечена как похожие результаты, то повторите поиск, включив опущенные результаты. Приложу скриншот «подопытного» сайта (надеюсь его автор на меня не обидится, а наоборот, примет меры по устранению проблемы, о которых я расскажу ниже):

В результате найдено 223 результата. Ну что же, не так и много, если сравнивать с тем, что было у меня: порядка более 300 ссылок были проиндексированы гуглом в тот роковой день и даже после запрета их индексации они появлялись еще в течение нескольких дней. Вот она знаменитая мгновенная индексация гугла! Яндекс за то время успел увидеть всего пару страничек.

Как устранить проблему с Replytocom

С помощью файла Robots.txt

Первое что приходит на ум — это редактировать файл robots.txt и добавить следующую строку:

Disallow: /*?replytocomЭто позволит запретить индексирование подобных страниц, но я поступил иначе. Так как у меня на блоге настроены постоянные ссылки (человеко-понятные урлы), то решил подстраховаться и сделать запрет на все страницы, содержащие знаки вопроса:

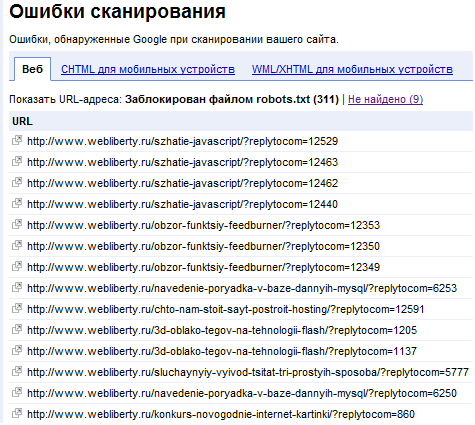

Disallow: */?И это работает! Чтобы проверить эффективность данного способа можете воспользоваться одним из инструментов вебмастеров Google: Просмотреть как Googlebot. Возвращаясь к своему блогу, также приведу скрин, из которого следует, что такие страницы успешно блокируются файлом robots.txt:

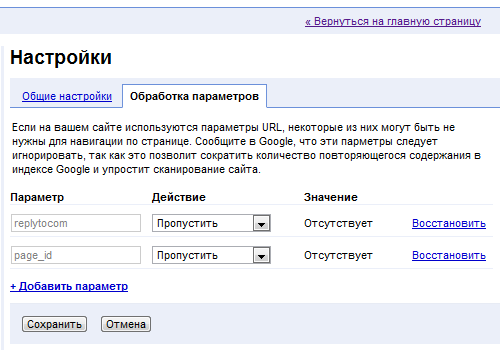

С помощью Google webmaster tool

Представляете, только недавно я узнал еще об одном очень полезном инструменте в панели для вебмастеров Google. Точнее я видел его, но не представлял зачем он и как им пользоваться. Оказывается он поможет не только сократить количество повторяющихся страниц в Google, но и помочь поисковой системе упростить сканирование сайта, путем исключения заведомо ненужных ссылок.

Находится этот инструмент в Конфигурации сайта, в пункте Настройки на вкладке Обработка параметров из интерфейса Google Webmaster Tool. По умолчанию у меня там уже стоял один параметр: page_id и редактировать его не пришлось.

Нажатием ссылки Добавить параметр появится еще одно текстовое поле, в которое и следует вставить параметр. У нас это Replytocom. Напротив этого параметра в выпадающем списке выбираем действие для Google: Пропустить. Вот и все, только не забываем нажать на кнопку сохранить. Таким образом, бот гугла, переходя по ссылкам и обнаружив в URL параметр Replytocom поисковый бот гугла проигнорирует (пропустит) его и не будет следовать по ссылке, а значит и не проиндексирует такую страницу.

Возможности такого метода очень широки, ведь его можно использовать не только для Replytocom, но и других параметров страниц, например фидов, комментариев и т.д. Google в очередной раз позволяет нам управлять своими сайтами, индексировать те страницы, которые требуется, вооружив таким инструментом.

С помощью плагина Replytocom Redirector

Существует также плагин для WordPress, который называется Replytocom Redirector, который редиректит поисковых ботов на основной адрес страницы, но, судя по отзывам других пользователей, плагин не справляется со своими обязанностями и ссылки с Replytocom все равно индексируются в Google.

Таким образом, можно выяснить небольшие проблемы, которые могут привести к более серьезной проблеме в будущем. А Вы постоянно следите за индексацией?

Спасибо большое за ценные советы. Я даже и не знал, что WordPress создает «Replytocom». Как говориться век живи, век учись. Подкоректировал свой robots.txt

Ответить

mindwork, пожалуйста) Сам до недавнего времени не знал про replytocom, пока не столкнулся с этим.

Ответить

Проверил свой роботс.тхт. В нем уже имелось

Видать не зря в свое время видеокурс Попова смотрел 🙂 За пост спасибо, многим думаю будет полезен.

Ответить

Киберсант, уже не в первый раз слышу про этот видеокурс, надо будет найти и посмотреть, раз многие на него ссылаются

Ответить

Интересно, по какому принципу генерируются страницы. Проверил все свои сайты, нигде подобной проблемы нет, хотя в robots.txt они не запрещены.

Ответить

BloggerMen, вот и я не понимаю, просмотрел много блогов и у большинства все нормально.. Хотя если в поиске ввести replytocom, то найдется не мало проиндексированных страниц…

Ответить

Не сильно то заботился сео аудитом, но в последние время проверил битые ссылки, вот теперь еще работки накопал у тебя на блоге 🙂

Спасибо за подсказку.

Ответить

Евгений, рад помочь) А ты я смотрю не закрываешь теги от индексации? А страницы переводов на другой язык зачем в индексе?

Ответить

Спасибо вам огромное за эту полезную инфу! Очень помогла!

А что вы думаете по поводу таких появляющихся страниц, как …/comment-page-1/ и так далее?

Ответить

Lovedancer, они появляются если в настройках поставлено ограничение числа комментариев на странице, у меня не ограничено, поэтому таких страниц нет. А Вам можно запретить такие страницы вот такой директивой в файле robots.txt:

Ответить

Webliberty, спасибо вам конечно огромное за помощь, но к сожалению я не могу заблокировать эти страницы… мало того, что страницы с комментами — это по своему оригинальный текст, так ещё у меня на этих страницах сдаются места под ссылки… так что, к сожалению, наверное за подобные страницы на меня и наложил санкции яндекс и гугль 🙁

А вы не могли бы подсказать, можно ли что-то такое прописать в коде wordpress, чтобы при переходе на вторую, третью, четвертую и так далее страницу комментариев, на странице не отображался уже сам пост, а отражались только комментарии?

Ответить

Спасибо вам огромное, про фишку в панели вебмастера google я вообще не знал! Нашел вашу статью по запросу replytocom в Яндексе, и как раз столько полезного для меня!

Ответить

Lovedancer, к сожалению не знаю как это осуществить, но на 100% уверен что это возможно, т.к. видел на каком то блоге… Вероятно есть специальный плагин, нужно искать.

Ответить

Если бы я раньше нашел такой косяк, а то у меня уже яндекс таких несколько тысяч страниц нашел. Теперь поправил robots.txt

Ответить

Дмитрий, бывает) Главное теперь остается ждать, когда же страницы с replytocom выйдут из индекса, можно ускорить процесс, если вручную удалять через специальную форму, хотя если страниц несколько тысяч — то проблематично…

Ответить

А я думаю, что это за реплайтукомы появились у меня в яндекс.вебмастере… А оно вон чего… Будем поправлять 🙂 Спасибо автору!

Ответить

Александр, пожалуйста. Также рекомендую прочитать этот пост, он дополнительно поможет понять чем опасны replytocom, ну и конечно же поправить ситуацию одним действенным способом.

Ответить

Спасибо большое за информацию. Теперь еще бы применить правильно. Древовидные комментарии закрыла, а вот с robots.txt еще не разбиралась. Может, плагин попробовать. У меня проблемы с Яндексом — Гугл более лоялен к таким вещам. Может, яндексу плагин закроет обзор?

Ответить

Надежда, если проблемы с Яндексом, то роботс на 100% решит проблему, он четко следует его инструкциям, в отличие от Гугла, который индексирует все и вся. Можете и плагин попробовать)

Ответить

Webliberty, бесконечно тронута Вашим вниманием и подсказками. Посмотрим, что натворила. Каков будет результат? И… я не очень бестактно поступила, с точки зрения гильдии вебмастеров, что не поставила ссылку на Ваш материал? Если не будете возражать, исправлю ситуацию? 😉

Ответить

Надежда Хачатурова, ну почему же, Вы описали свое видение проблемы, своими словами, не копировали — на это каждый имеет право)

Ответить

Денис, а в «инструментах для вебмастеров» от Google как теперь настроить параметр запрещающий индексировать Replytocom? Я заметил, что он теперь выглядит немного по другому Конфигурация сайта-Параметры URL-Настройка параметров URL. у меня там стоит параметр replytocom, Что должен сканировать робот Googlebot стоит На усмотрение робота Googlebot (по умолчанию) выбрал изменить, но я не пойму, что там нужно сделать

Ответить

Дмитрий, после глобального редизайна Гугла панелька видоизменилась. Чтобы исключить из индекса урлы с replytocom на конце необходимо напротив этого параметра нажать на ссылку Изменить и в списке выбрать:

Затем сохранить изменения. В итоге напротив параметра появится надпись: Один выбранный URL. Т.е. все ссылки с параметром будут вести на каноническую страницу и не попадут в индекс.

Ответить

Спасибо Денис! А древовидность комментариев обязательно отключать? Просто когда я их отключаю, у меня пропадает в комментариях кнопка ответить и дизайн комментариев становится не очень

Ответить

Дмитрий, можно и не отключать, но Гугл может проигнорировать и роботс и эти настройки обхода параметров. Собственно, именно так он с моим блогом и поступил, поэтому я отключил древовидные. А так в принципе, можно и не отключать.

Ответить

Я вроде все поотключал, но Гугл выдает результаты индексации 1400/1. Никак не пойму.

Ответить

Юрий, должен пройти достаточный промежуток времени, прежде чем Google учтет изменения, выкинет replytocom и прочие дубли из индекса. В который раз повторюсь — в поиске должно находиться примерно столько же страниц, сколько их на самом деле имеется. Неужели у Вас написано 1400 постов?

Ответить

Webliberty, да нет, конечно, около 80 страниц. Я смотрел у других блоггеров процент побольше чем у меня. У меня рекорд. Robots.txt ничем от моего не отличается. Со временем, думаю, что разберусь.

Ответить

Денис, огромное спасибо! MegaIndex мне в лицо тыкал «неудовлетворительно» по 5 позициям блога. Не могла понять в чем дело. Понимаю, что дубли, а как избавиться не знала. Прямо сейчас прочитала Вашу статью, изменила robots, убрала древовидные комментарии и ограничение комментариев на странице. Заказала переиндексацию и,О, ЧУДО! По всем позициям ОТЛИЧНО. Благодарю еще раз!

Ответить

Судя по Вашему методу Вы все таки не указали в файле robots.txt Disallow: /*?*, так как Вы все таки решили проблему? Судя по всему отказались от древовидных комментариев…

Ответить

Владислав, все верно, пришлось отказаться от древовидных комментариев, более того, даже после этого ссылки с replytocom по-прежнему оставались в выдаче. Пришлось действовать радикально, применяя этот скрипт и затем вручную удалять страницы из выдачи.

Ответить

Маргарита, выбирайте не влияет, т.е. наличие этого параметра в адресе не изменяет содержание страницы.

Ответить

Денис, у мня в роботсе стоит

А в инструментах гугля, создавая параметр Replytocom нужно выбрать «влияет» или «не влияет»?

Ответить

Спасибо, сам недавно увидел, что их все больше и больше… Добавил нужные значения в файл robots.txt…

Ответить

А если у меня гугл не показывает replytocom, значит все в порядке с древовидными? Может, обновленный вордпресс исправил этот недочет?

Ответить

Лариса, я почти поверил в Ваши слова, но решил проверить, и… Перейдите в Google и в строке поиска введите следующее:

site:doroad.ru replytocomКак видите, о таких страницах Гугл знает, просто не включает их в основную выдачу, а прячет на последней странице результатов поиска под ссылкой «Показать скрытые результаты».

Наличие этого параметра у Вордпресс — это не недочет и уж точно не ошибка, а некая особенность, позволяющая формировать древовидную структуру. Следить за правильностью индексирования — одна из основных задач вебмастера.

Ответить

Webliberty, да, вчера обнаружила… Но при этом у меня в роботс уже была строчка

Добавила еще вторую, загрузила… и сайт пропал 😮 Может, конечно, что-то на хостинге было и так совпало… в общем, сделала откат. Теперь сайт есть, а файлов на хостинге не видно. Пойду в техподдержку писать.

А у яндекса с этим проблем нет пока, так?

Ответить

Лариса, ни у Яндекса, ни у Гугла вообще нет проблем 😀

Ответить

Webliberty, кто бы сомневался 😀 Ну Вы же поняли вопрос? Яша не обращает внимания на эти древовидные косяки?

Ответить

Яндекс 100% выполняет все правила robots.txt, поэтому если URL закрыты, то можете быть уверены что он их не проиндексирует.

Ответить

Это снова я. Не могу найти там «конфигурацию сайта» и «настройки». Наверно, за два года интерфейс поменялся?

Ответить

Да, интерфейс с тех пор претерпел изменения. Найти и изменить параметры URL для эффективного сканирования сайта можно в разделе Сканирование.

Ответить

Webliberty, я отключила древовидные, и теперь стало ничего не понятно. А как сделать, чтоб хотя бы обращение появлялось при ответе, как у Вас?

Ответить

Лариса, посмотрите https://webliberty.ru/knopki-otvetit-i-tsitirovat-v-kommentariyah/

Ответить

Тоже столкнулся с дублями страниц. Яндекс говорит, что у меня дубль есть на одну страницу и не индексирует ее. У меня древовидные комментарии, но у других тоже такие и у них все нормально.

Ответить

Денис спасибо за статью, но все эти манипуляции не помогают. Уже что только не перепробовал. 24000 дублей страниц в гугле.

Тут или ставить плагин WordPress Thread Comment или делать комменты как у тебя. Кстати у тебя дублей нет.

Скажи, удобно так отвечать?

Ответить

Александр, более радикальный метод избавления от таких дублей изложен здесь, вот только подходить к нему нужно с осторожностью.

Плагин — а почему бы и нет, я пробовал устанавливать его, но придется настраивать внешний вид, т.к. по-умолчанию он страшненький. Вот только не обновлялся он давно, вероятно есть проблемы с безопасностью и совместимостью.

Удобство — это субъективно, я привык. Если долго не затягивать с ответом, то логическая цепочка обсуждения не потеряется.

Ответить

Webliberty, если нужен плагин этот исправленный, то напиши мне в поддержку. Мне специально сделали его, чтобы стили настраивались нормально и комменты друг за другом шли, а не внутри другого с рамками.

Все верно, там уродливо! 😐

Ответить

Александр, да нет, спасибо) Все уже настроено, нет в нем необходимости.

Ответить

Проверил свой сайт. Выдал — «По запросу site:wpnice.ru replytocom ничего не найдено.» Хотя раньше ничего специально не делал.

Ответить

И что теперь этот список урлов-replytocom вылезет в ошибках сканирования, после того как я в «параметрах URL» запретила их индексировать?

Ответить

Dmitry, это дело случая. Стоит роботу один раз обнаружить такую ссылку, как сразу же начнет «шерстить» весь сайт на наличие подобных. А уж если найдет — так и будет сканировать, даже несмотря на запрет в роботсе. В большей степени это касается Гугла.

Ирина, ничего страшного, обновление данных займет некоторое время, после чего ошибки сканирования таких ссылок должны исчезнуть из отчетов.

Ответить

Спасибо! Также столкнулся с данной проблемой, хотя Сео плагин борется с данным replytocom, закрыть индексацию в robots.txt будет не лишним, так как сделав аудит в мегаиндекс выдало дубль именно в replytocom, тобышь благодаря комментариям. Закрыл ожидаю новых результатов

Ответить

Какой кипиш был тогда из за этого… Я не стала в коде возиться, установила плагин. И это нормально, хотя в настройках обсуждения я установила Разрешить древовидные (вложенные) комментарии глубиной 10 комментариев. Выход всегда есть, если подумать хорошо, ведь в поисковиках все ответы есть.

Ответить